コンサート

Max Summer School in Geidai 2022本プログラムはどなたでもご覧いただけます。 Anyone can watch this program.

視聴はこちら Watch archive here2022/8/5 18:00より上記YouTubeチャンネルにて配信します Live stream starts at 6pm, 8th Aug. 2022

本コンサートは受講生以外の方にもご来場いただけます。

日時:8月5日 18時より

場所:東京芸術大学 千住キャンパス 第7ホール

〒120-0034 東京都足立区千住1丁目25−1 (Google Map)

入場料:無料(どなたでも予約なしでご入場いただけます)

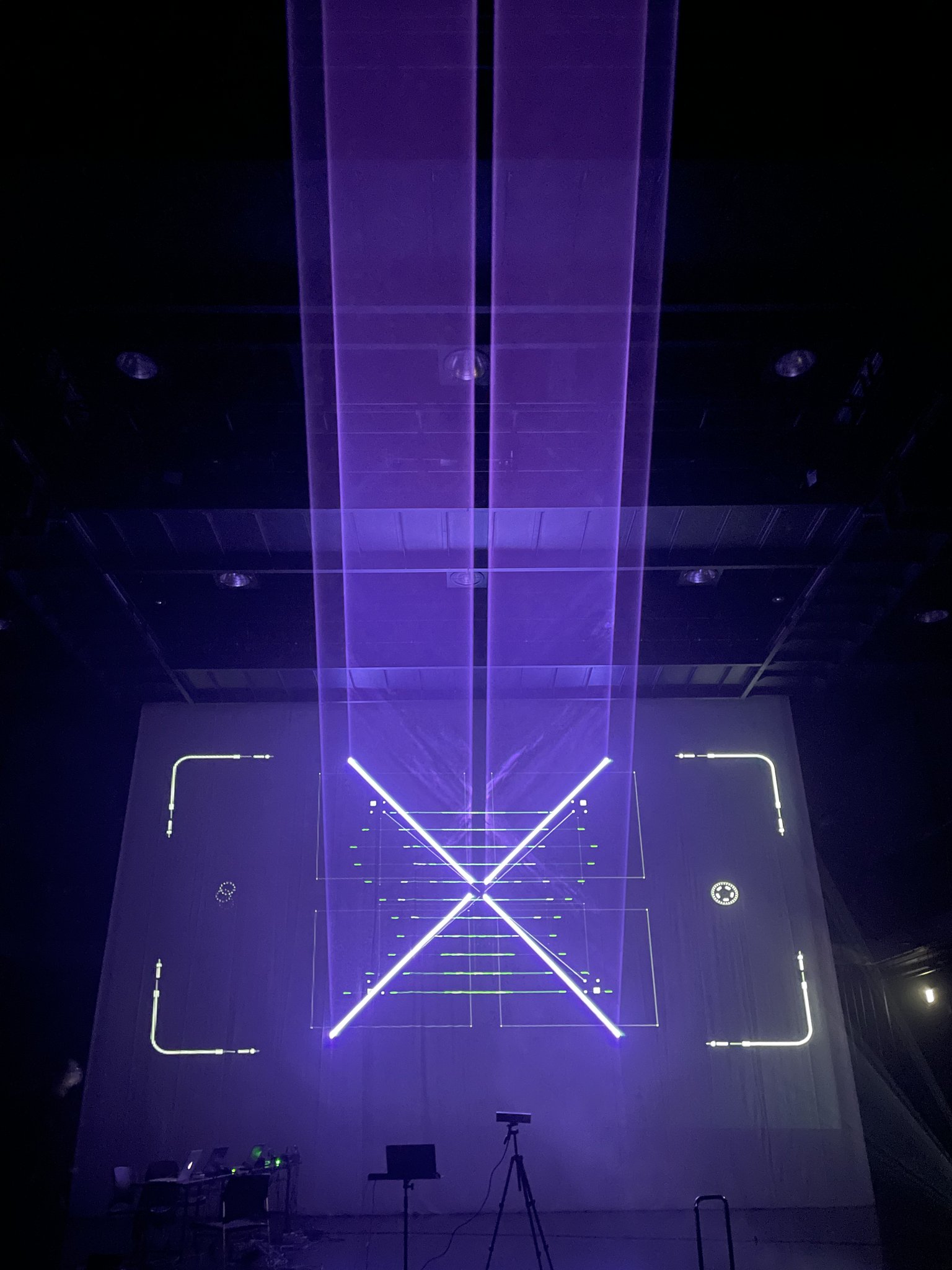

「Study for Trombone, Interactive System, and Visual Media」

後藤英

1. 第1セクション:トロンボーンとライブエレクトロニクス、レーザーと映像の習作

2. 第2セクション:トロンボーンとKinect、レーザーと映像の習作

3. 第3セクション:トロンボーンとWii、レーザーと映像の習作

4. 第4セクション:トロンボーンとライブエレクトロニクス、レーザーと映像の習作

作曲、コンセプト

後藤英

映像

横山徹

レーザー

秋山大知

アシスタント

鄭瑀

演奏者

村田 厚生 (むらた こうせい) トロンボーン

桐朋学園大学音楽学部卒業。ドイツ学術交流会(DAAD)給費留学生としてベルリン芸術大学卒業。

現代トロンボーン音楽のスペシャリストとして内外の現代音楽祭に出演。モーションセンサーとリアルタイム・エフェクト、またグロボカール作品に焦点をあてたシリーズリサイタルを継続中。ユニット「コンテンポラリー・デュオ 村田厚生&中村和枝」ではドイツ、スイス5都市でリサイタルを行った。サイト上での奏法解説は作曲家の定番解説書としてレパートリーの開発に貢献している。ソロ・アルバム「Just Sing」、自作を含む前衛作品を収録した「Slide Paranoia」をリリース中。

桐朋学園芸術短期大学非常勤講師。ウェブサイトwww.sonata.jp

編成

Trombone, Interactive System, and Visual Media

1. Section 1: Study for trombone and live electronics, laser and images

2. Section 2: Study for rrombone and Kinect, Laser and images

3. Section 3: Study for trombone and Wii, laser and images

4. Section 4: Study for trombone and live electronics, laser and images

Composition, Concept

Suguru Goto

Images

Toru Yokoyama

Laser

Daichi Akiyama

Assistant

Yu Zheng

Performaer

Kousei Murata - Trombone

編成

Trombone, Interactive System, and Visual Media

Between Me and Myself I (2015)

Andreas Eduardo Frank (DE)

概要

3分割された演奏と実演とのシンクロナイズ

演奏時間

10分

演奏者

村田 厚生

編成

Trombone、映像

ヒューマンロボットチャネリング(2022)

磯部英彬

概要

そろそろ真剣にロボットが宇宙と交信する時が来たと考える。この曲は「宇宙とロボットの対話」をテーマしている。古代より人間はチャネリングという作業により宇宙との交信を試みてきた。人間はチャネリングで宇宙と交信することにより様々な過去、未来の情報を得ることができた。いわゆる”シャーマニズム”に近いものである。しかし人間がチャネリングにより宇宙と交信する作業には、交信を行なった人間”霊媒師”とそれ以外の人間の間では共有ができない不確定な要素が沢山含まれており、その一つ一つの情報には交信を行なった人間”霊媒師”の個人的な経験や思いも多く含まれている。そのような”霊媒師”が行う非常に客観性の乏しい行為をロボットが作業として行うとどのようになるのかという興味からこの曲を作曲した。この楽曲はロボットから発せられた音をサンプリングした音とサイン波やホワイトノイズを元に構成されている。ミクロに発せられた電子音を間接的にラウドスピーカーにより拡声することで、音の輪郭が変化し電子的なものにある生命のようなものを感じることができるのではと考える。ある意味ロボットとは”簡素化”されたチープな情報を人間が拡大解釈することにより生まれる客観性のある”霊媒師”のような存在なのではないかと考える。

演奏者

磯部英彬

編成

Max

うじゃうひじゃう Ujau-Hijau - "Thing with heart and Thing without heart"

由雄 正恒 YOSHIO Masatsune

概要

音を手段として人間の意思を伝達する行為,

それは音楽家のジェスチャー.

ジェスチャーにはmotion[身振り/手振りといった動作/動き]をともなう.

motionは人間の視覚に直接見える動作.

人間の視覚に直接見えない動作(人間の内なる動作) - emotion [感情].

emotionを誘発する音楽 - 音楽と感情.

月並みなことだが,

人間に対するコンピュータの違いについて,

音楽には感情がつきものだがコンピュータが感情をもって訴えることはない,

というのがある.

感情のある音楽と感情がないコンピュータ(感情がないというよりかはrational[理性的]なコンピュータか).

今作では,

コンピュータ音楽における有情と非情(うじゃうひじゃう)の関係について,

音を手段として作家の意思を伝達したいと思う.

演奏時間

10分

編成

Max

Human Learning x Machine Learning

Four pieces for human body and machine learning system

Atau Tanaka

@atautanaka (Twitter) / @atautana (Instagram)

https://www.gold.ac.uk/computing/people/tanaka-atau/

This performance presents a historical and up to the minute account of working with the body as musical instrument. Physiological signals of the body, muscle tension reflected in the electromyogram (EMG) become a means of musical performance. Electrical impulses from the nervous system causing muscle tension, allows the performer to articulate sound through concentrated gesture. They enter into interaction with machine learning algorithms that create models of associations between corporeal gesture and computer-generated sound. The four pieces reflect different modes of interaction with sound, machine learning, and ultimately the body itself.

Lifting (2003)

Whistling oscillators are modulated in frequency and amplitude, recalling the classical Theremin.

Delearning (2019)

Takes as its source a work by Tanaka for chamber orchestra, DSCP (originally performed by Artzoyd and Ensemble Musiques Nouvelles), as sound corpus for analysis and subsequent neural network regression. Feature extraction of arm poses are associated with audio metadata (using IRCAM’s CaTART) and used to train an artificial neural network. The algorithm is then put into performance mode allowing the performer to navigate a multidimensional timbre space with musical gesture.

Myogram (2015)

A direct sonification of muscle activity where we hear the neuron impulses of muscle exertion as data. Throughout the piece, the raw data is first heard, then filtered, then excite resonators and filters.

Rapidregress (2019)

An homage to Michel Waisvisz, his work at the studio STEIM in Amsterdam and his performances on the instrument, The Hands. On one arm a short recording of a Waisvisz performance is articulated. On the other, an electronic music track, Delull by Tanaka. These two sources are granulated and placed in counterpoint. Two neural networks create independent regression models associating static posture and sound grain for each source. Once in “test” mode, these models take dynamic gesture, deconstructing the two prior works into a single improvisation.